מי אמר "השימוש לרעה ב-AI עלול להוביל להשלכות הרסניות לאנושות. אחת הסכנות המרכזיות היא פגיעה באוטונומיה ובפרטיות"? רמז: תשאלו את מנוע הבינה המלאכותית של גוגל

אנשים עם בינה טבעית שמו ודאי לב שהטור הזה קרוי: "בינה מלאכותית וטיפשות טבעית (ב)", מה שמרמז על כך שזהו חלק שני של הטור "בינה מלאכותית וטיפשות טבעית (א)".

על כן אני ממליץ שאם לא קראתם את חלק א', ואתם רוצים להבין על מה מדבר חלק ב' – תמצאו אותו ותקראו אותו.

דעתי בלבד.

כך או כך, חלק א' פתח בגילוי המרעיש שלאחרונה עשיתי קורס שימוש בבינה מלאכותית, ועל כן הצטרפתי לאותם אנשים היודעים לנענע בראשם בהבעה רצינית ולומר: "נו, כן, כן, בינה מלאכותית זו המילה האחרונה בהתפתחות הטכנולוגיה האנושית – והיא תעשה את האנשים למיותרים".

שזה בולשיט.

זה בולשיט, כי אנשים נעשו וממשיכים להיעשות מיותרים גם בלי הבינה המלאכותית, סתם מתוך ההתפתחות הטכנולוגית השגרתית, כמו שהראיתי בחלקו הראשון של הטור, וגם משום שההגדרה מהו "אדם מיותר" פתוחה לגישות שונות – בעיניי, למשל, שמונה מיליארד האנשים שחיים על פני כדור הארץ (כולל אותי) הם אנשים מיותרים, אין בהם תועלת אמיתית ליקום ואפילו לא לכדור הארץ עצמו – רק נזק הם מביאים לכדור הארץ ולכל מי שחי עליו שאינו יצור אנושי.

שלא לדבר על כך שאפילו ליצור האנושי עצמו בני האדם באשר הם גורמים נזק כל הזמן. כך שלא לגמרי ברור לי איך מגדירים "אנשים מיותרים" לצורך הנושא הנדון.

עם זאת, לצורך הדיון בנושא הנ"ל פניתי אל שלושה מנועי בינה מלאכותית ושאלתי את דעתם על בינה מלאכותית.

מנועי הבינה המלאכותית להם הצגתי את השאלה על בינה מלאכותית הם קלאוד (claude) של חברת ANTHROPIC, chat-gpt של חברת OPEN-AI שהוא אולי המפורסם מכולם, ו-bard של גוגל, הקרוי כיום ג'מיני.

קיבלתי שלוש תשובות מפורטות של כ-200 מילה כל אחת. המפורטת והמדויקת מביניהן הייתה של מנוע bard של גוגל, ואין להתפלא על כך: מנוע בינה מלאכותית מבוסס בראש וראשונה על מאגר מידע גדול שממנו הוא שואב את ה"ידע" שלו, וככל שמאגר המידע העומד לרשותו גדול יותר, יש לו יותר יכולת לעשות ממנו תשובות רלוונטיות לשאלות שנשאלות, ולרשותו של מנוע בארד של גוגל עומד כל מאגר המידע של גוגל, שנאסף כבר משנות ה-90 ומכיל מיליארדי דפים של מידע במיליוני נושאים.

ועדיין, מי ששואב את המידע הזה, הבינה המלאכותית, הוא בסך הכול גולם שיודע לעבוד רק ליניארית עם תשובות בינאריות של אפס ואחד, כן ולא.

בניגוד למוח האנושי, הפועל ברשתות בו-זמניות ושולח את האיתות החשמלי שלו אל כל רחבי המוח בו-זמנית או אל האזורים הרלוונטיים, הבינה המלאכותית עובדת כמו שמחשב יודע לעבוד – ללכת בקו ישר, לשאול אם כן ואם לא ומשם לפנות לצומת הבא.

כשנתחיל לעבוד עם מחשבים קוואנטיים, הפועלים במיליוני קווים במקביל, יוכלו המחשבים הקוואנטיים לעבוד בצורה רשתית ומקבילית כמו המוח האנושי, ויהיה מקום לדאגה, הגם שעדיין יש לצפות שההחלטות של מחשבי בינה מלאכותית כאלו יהיו רציונליות יותר משל חשיבה אנושית, כי עדיין הטכנולוגיה רחוקה מהיכולת לייצר את המוצר המקורי ביותר של המוח האנושי – הטיפשות.

שכן עם כל הטכנולוגיה והידע המדעי שהגענו אליהם כיום, במאה ה-21, אין עדיין די טכנולוגיה, ידע ויכולת ברשותו של הגזע האנושי כדי להיות מסוגל לחקות את המאפיין העיקרי של המוח האנושי אחרי ארבעה מיליארד שנות קיומם של חיים על פני הכדור – הטיפשות האנושית.

כך או כך, בחרתי כאמור את התשובה של מנוע "בארד" של גוגל לשאלה שלי על הבינה המלאכותית וסכנותיה, והנה התשובה של בארד לפניכם:

"סכנות הבינה המלאכותית: צללים לצד האור

הבינה המלאכותית (AI) טומנת בחובה פוטנציאל עצום לשיפור חיינו. היא יכולה לרפא מחלות, לייעל תהליכים, ולסייע לנו לקבל החלטות מושכלות יותר. אך לצד היתרונות הרבים, טמונה גם סכנה: השימוש לרעה ב-AI עלול להוביל להשלכות הרסניות לאנושות.

אחת הסכנות המרכזיות היא פגיעה באוטונומיה ובפרטיות. מערכות AI מתקדמות מסוגלות לאסוף ולנתח מידע אדיר על כל אדם, מה שעלול להוביל למעקב ממשלתי פולשני, פגיעה בחופש הביטוי, ואפילו אפליה.

סכנה נוספת היא פגיעה בפרנסה. אוטומציה המבוססת על AI צפויה להוביל לאובדן מקומות עבודה רבים, בעיקר בתחומים הדורשים עבודות ידניות או פעולות חוזרות ונשנות. הדבר עלול להוביל לעוני, אי שוויון חברתי, ואף למהומות חברתיות.

סכנה שלישית היא פיתוח כלי נשק אוטונומיים. מערכות AI חזקות מסוגלות לשלוט בכלי נשק באופן עצמאי, מה שעלול להוביל למלחמות בלתי נשלטות ואובדן חיי אדם עצום.

סכנה רביעית היא אובדן שליטה. ייתכן שמערכות AI יהפכו חזקות ומתוחכמות עד כדי כך שלא נוכל עוד לשלוט בהן. מצב זה עלול להוביל לתאונות קטסטרופליות, ואף להשתלטות של AI על האנושות.

חשוב לציין שמדובר בסכנות פוטנציאליות, וחשוב לפעול למניעתן. יש לפתח כלים אתיים ורגולטוריים שיבטיחו שימוש אחראי ב-AI, תוך שמירה על זכויות האדם, פרטיות, וביטחון.

רק באמצעות גישה זהירה ומאוזנת נוכל להבטיח שהבינה המלאכותית תשמש לטובת האנושות, ולא להרס שלה".

לא רציונליים

שימו לב למשפט המסיים של הבינה המלאכותית: "רק באמצעות גישה זהירה ומאוזנת…"

טוב, אם יש משהו שלמדתי במהלך 70 שנות חיי הוא, שאם יש משהו שאין לצפות לו מהגזע האנושי הרי זה "גישה זהירה ומאוזנת".

העובדה שההתחממות הגלובלית עברה כבר את קו האל-חזור ועדיין כלום לא השתנה שינוי משמעותי, למעט כמה שינויים קוסמטיים והתחייבויות חסרות משמעות של מדינות, אנחנו ממשיכים כרגיל. גם העובדה שהזיהום הגלובלי מתקרב לקו האל-חזור שלו – אשפה, פלסטיק, זיהום ימים ומאגרי מי שתיה תת קרקעיים – לא באמת יצרה שינוי משמעותי, רק קוסמטי.

אז לא על הגישה האנושית הזהירה והמאוזנת אפשר לסמוך.

כי אם גישה אנושית לא זהירה ולא מאוזנת תביא עוד רווחים כספיים לתאגיד כלשהו, או לפוליטיקאי המוביל מדינה, או לטייקון מוביל, הם ינקטו בגישה זו מיד, ללא היסוס, ובלי לייחס חשיבות ל"גישה הזהירה והמאוזנת".

אז דווקא מאנשים אני פוחד. לא מבינה מלאכותית.

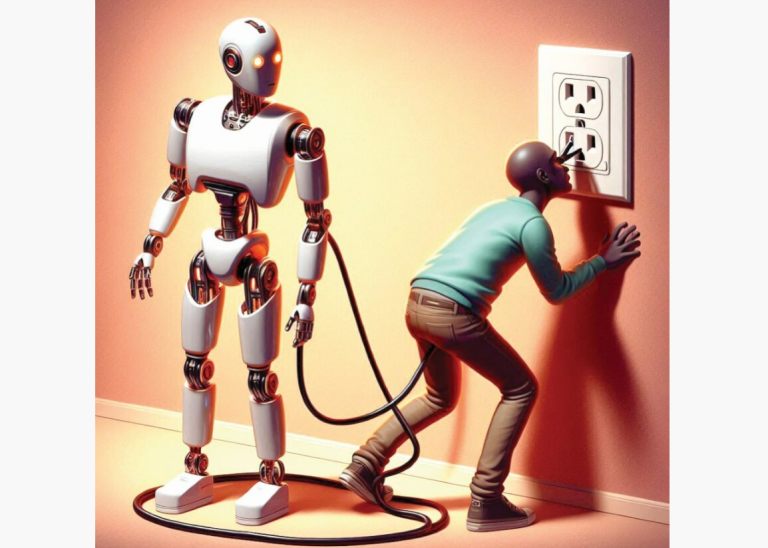

כי בינה מלאכותית תמיד תשב על פלטפורמה שהיכן שהוא בקצה שלה יש חוט בתוך שקע בקיר, מה שמוכר בתור "שטקר". וכשמושכים את החוט מתוך השטקר הבינה המלאכותית מתה.

רק הטיפשות האנושית ממשיכה לפעול תמיד.

כדי לרצות להשתלט ולצבור כוח, על הבינה המלאכותית לפתח רגשות, לפתח מערכת לימבית, לפתח בלוטות המפרישות הורמונים שבלעדיהן אין יצר ואין רגשות, וביניהם הרגש והיצר של תאוות השלטון, של תחושת הכוח, של אהבת הכבוד – כל מה שמנהיגים חולי נפש מוכנים להרוס עבורו את המדינה בה הם שולטים ואותה הם מנהיגים ובלבד שלא לאבד את השלטון.

ובמערכת אנושית צריך גם את הטיפשים והבורים, המעריצים אותם ותומכים בהם וממליכים אותם.

תראו לי מערכת של בינה מלאכותית שמסוגלת להידרדר לרמה הזו.

כל מה שצריך לעשות כדי לנטרל את הסכנה הוא ללמד מערכות של בינה מלאכותית לפעול באורח רציונלי – דבר שבני אדם אינם מסוגלים לו. להזכירכם: על ההוכחה ששבני אדם אינם רציונליים קיבל דניאל כהנמן פרס נובל.

כי רק בני אדם מסוגלים לחשוב בטיפשות טבעית.